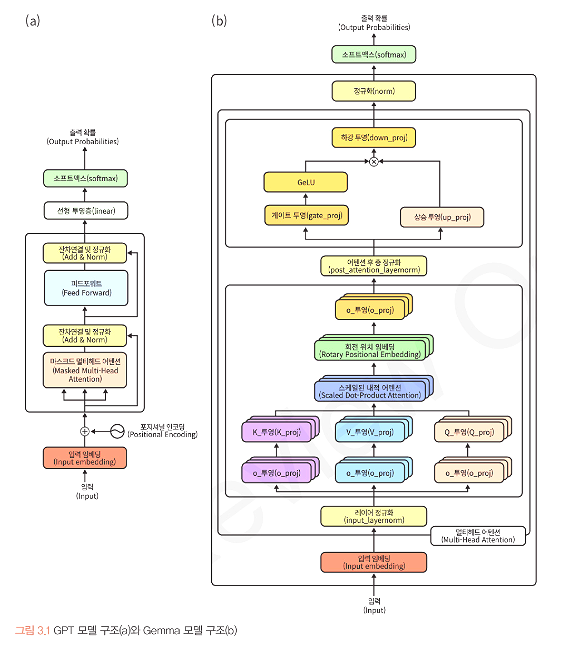

3.2 Gemma와 Llama3 모델 구조 분석 3.2.1 Gemma 모델 구조 분석매개변수(7B, 13B, 34B, 72B 등)의 수를 늘려서 성능을 높이는데 집중했던 재부분의 모델들과는 반대로 모델의 크기를 크게 줄여서 고성능 컴퓨팅 자원이 부족한 환경에서도 언어모델을 황용할 수 있게 하려는 혁신적인 시도a. input_layernorm, post_attention_layernorm 추가 : 그레디언트를 적절한 크기로 유지 → 안정적 학습, 더 좋은 성능b. RoPE(Rotary Position Embedding) 도입 : 각 토큰의 위치를 상대적인 각도로 표시c. 활성화 함수 : ReLU의 한계를 극복하기 위해 GELU와 GLU를 결합한 GeGLU라는 새로운 활성화 함수를 사용 3.2.2 Gemm..