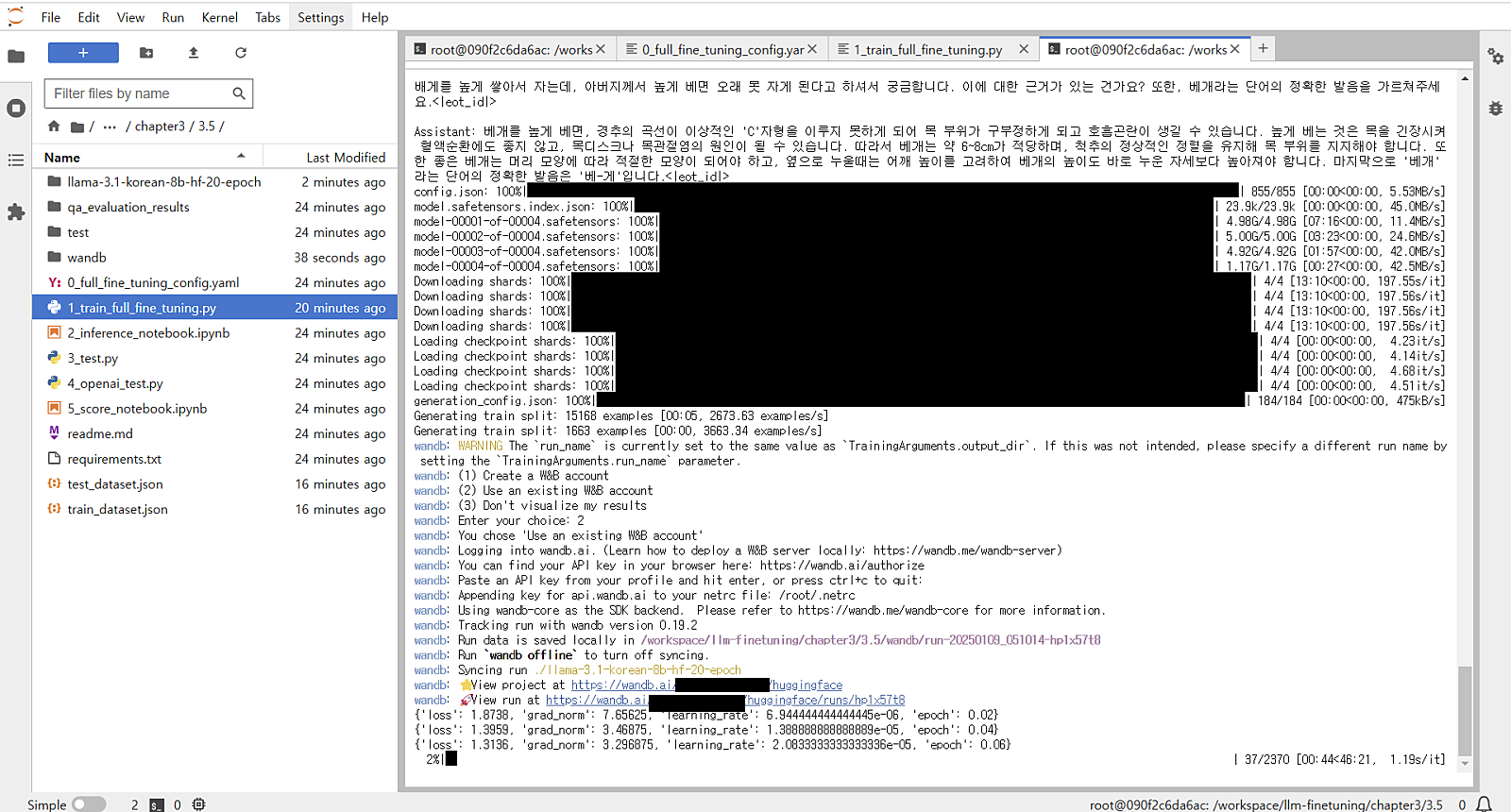

3.5 다중 GPU를 활용한 Llama3.1-8B-instruct 파인 튜닝 3.5.1 런팟 환경 설정H100XM x 41Pytorch 2.2.0Container Disk 400GBVolume Disk 400GBgit clone https://github.com/wikibook/llm-finetuningcd llm-finetuning/chapter3/3.5pip install -r requirements.txt 3.5.2 Llama 3.1 학습 파라미터 설정model_name : 사용할 모델 ID, 허깅페이스에 등록된 모델 이름dataset_path : 학습에 사용할 데이터셋이 위치한 경로max_seq_length : 모델이 처리할 수 있는 최대 시퀀스 길이 설정output_dir : 학습과정에서 생성..