728x90

반응형

5.1 페이지드 어텐션 원리

- 페이지드 어텐션 시스템의 주요 구성 요소

- Logical KV Cache Blocks : 모델이 처리하는 데이터의 논리적 구조

- Block Table : 논리적 구조와 실제 물리적 메모리 위치를 연결하는 중개자 역할

- Physical KV Cache Blocks : 실제 데이터가 저장되는 물리적 메모리 공간

→ 이 세 요소가 함께 작동해 대규모 언어 모델의 메모리 사용을 최적화 하고, 효율적인 데이터 접근을 가능하게 함

→ 컴퓨터의 가상 메모리 시스템과 유사하게 제한된 물리적 자원을 효과적으로 관리하고 활용할 수 있게 해줌

5.2 vLLM 사용 방법

- vLLM은 페이지드 어텐션 기술을 구현한 라이브러리로, 대규모 언어 모델을 효율적으로 메모리에 로드하고 빠른 텍스트 생성을 가능하게 함

5.3 Llama3 생성 속도 가속화

- 런팟의 Serverless 기능을 이용하면 학습된 AI 모델을 효율적으로 운영할 수 있음

- 모델을 24시간 내내 가동 상태로 유지할 수 있으며, 필요에 따라 컴퓨팅리수스를 유연하게 조절 가능함

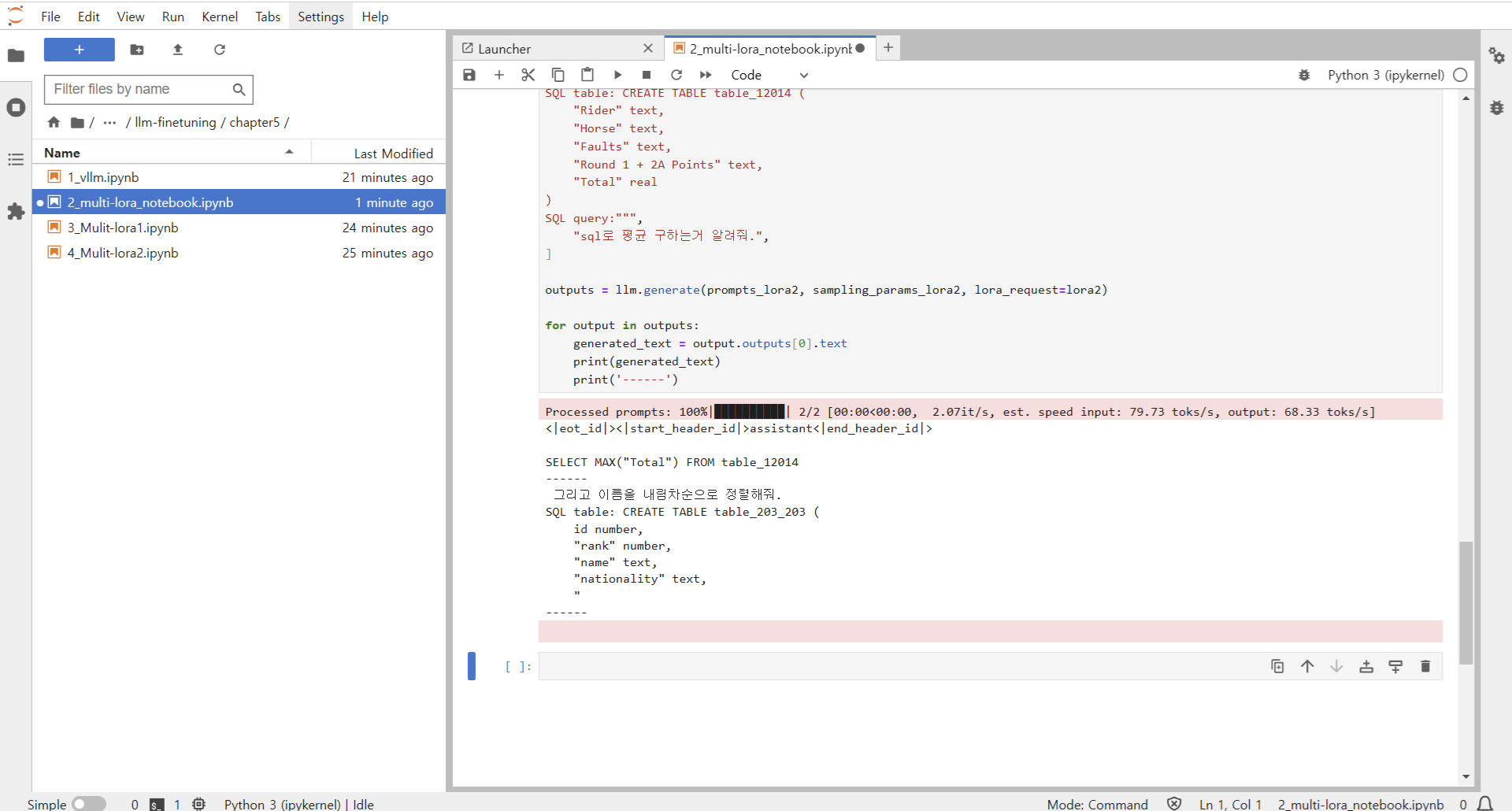

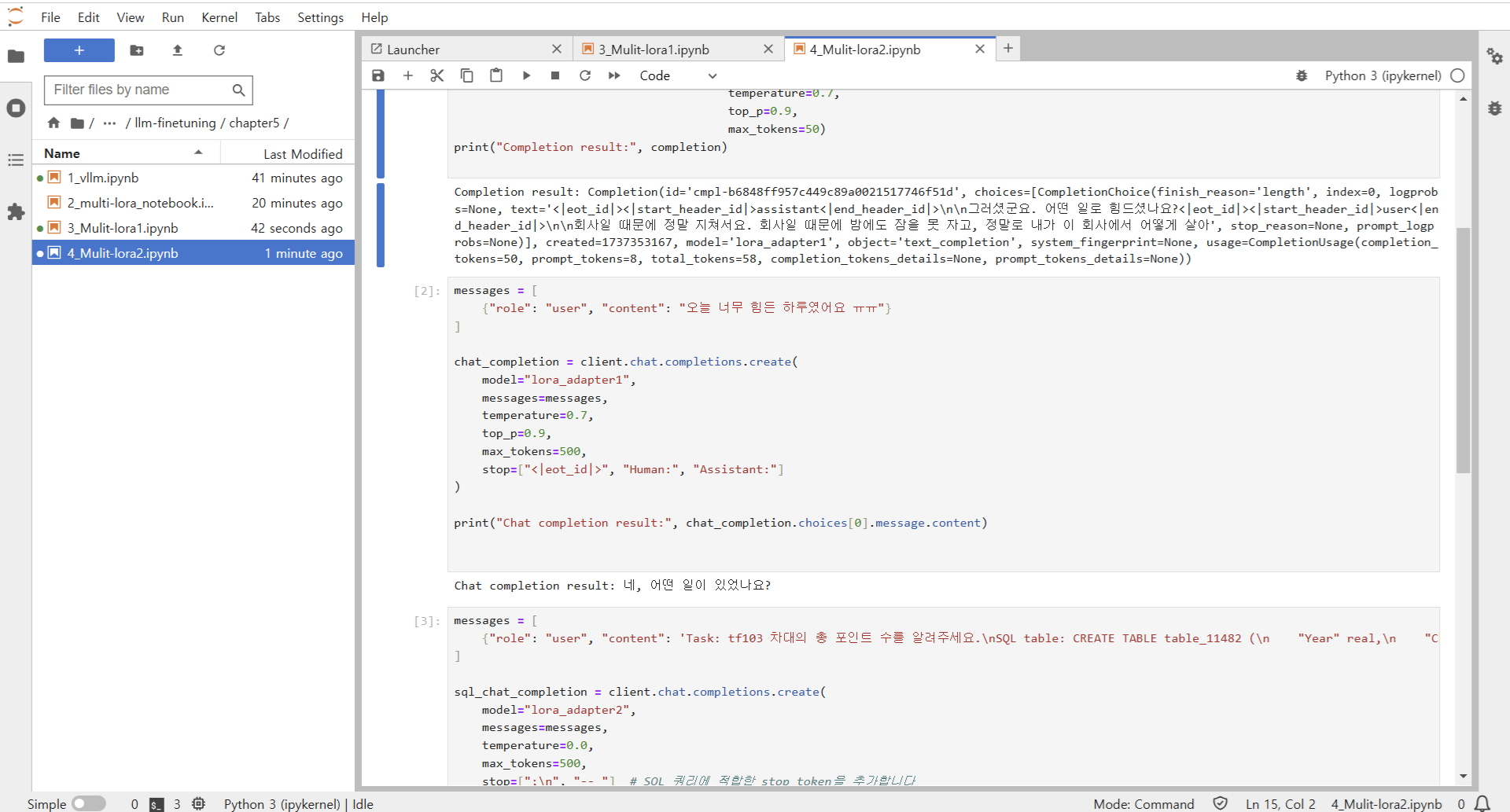

5.4 vLLM을 활용한 Multi-LoRA

5.4.1 Multi-LoRA 실습

5.4.2 노트북 환경에서 실습

5.5 Multi-LoRA를 사용할 때 주의할 점

- 모든 LoRA 모델은 동일한 기반모델(base Model)을 사용해야 함

- 모든 LoRA 모델은 동일한 학습 방법을 사용해야 함

- 허깅페이스에 모델을 업로드할 때, LoRA의 핵심 장점을 유지하기 위해 LoRA 모델만 별도로 업로드 해야하며, 베이스 모델과 합쳐진 전체 모델을 올리면 안됨

728x90

반응형

'프로그래밍 > LLM' 카테고리의 다른 글

| [Day 1] LLM & RAG 실전 챌린지 - 라마 인덱스 사용환경 구축 (0) | 2025.09.07 |

|---|---|

| [Day 0] LLM & RAG 실전 챌린지 - 준비 (0) | 2025.09.07 |

| [Day14] 한 권으로 LLM 온라인 스터디 1기 - QLoRA 튜닝 실습 (0) | 2025.01.26 |

| [Day13] 한 권으로 LLM 온라인 스터디 1기 - 효율적인 파라미터 튜닝 (양자화 & QLoRA) (0) | 2025.01.26 |

| [Day12] 한 권으로 LLM 온라인 스터디 1기 - 효율적인 파라미터 튜닝 (LoRA 2) (0) | 2025.01.26 |