728x90

반응형

7.1 개발 환경 구축하기

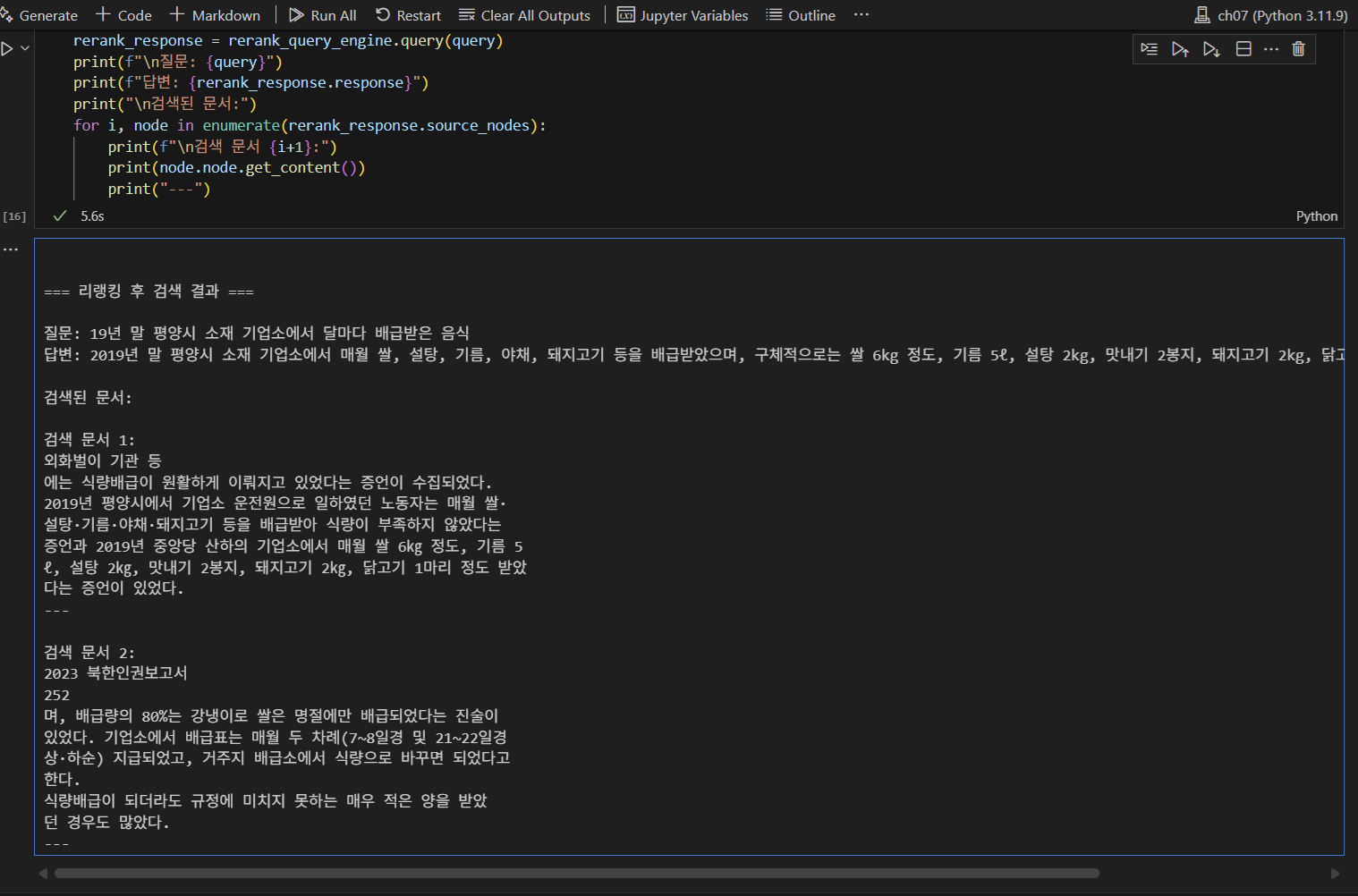

7.2 리랭킹

- LLM 기반 리랭킹은 대규모 언어 모델(LLM)을 활용해 초기 검색 결과를 다시 평가하고, 사용자의 질문과 가장 관련성이 높은 순서로 결과를 정렬하는 방법

- LLM 은 초기 검색 결과를 전체적으로 검토함

- LLM이 새롭게 계산한 점수를 기준으로, 기존 임베딩 모델의 겸색 결과를 다시 정렬함

[ 기본 RAG ]

- 벡터 검색으로 상위 4개 문서를 찾아옴

- LLM 호출 1회 : 검색된 4개 문서 전체를 바탕으로 답변을 생성

- 총 LLM 호출 : 1회

[ 리랭킹 적용 RAG ]

- 벡터 검색으로 상위 4개 문서를 찾아옴

- LLM 호출 4회 : 각 문서와 질문의 관련성을 1-10점 사이로 평가함

- LLM 호출 1회 : 관련성 점수가 높은 상위 2개 문서를 이용해 답변을 생성

- 총 LLM 호출 : 5회

7.3 LLM 기반 리랭킹 비용 문제

- 리랭킹은 각 문서를 평가하기 위해 LLM API르 ㄹ개별 호출해야 하기 때문에 비용이 많이 들고 처리시간이 길다는 단점이 있음

- 비용 문제를 해결하기 위해 대부분의 실무에서는 LLM 기반의 리랭킹 방식 보다는 BAAI/bge-reranker와 같은 리랭킹 특화 모델을 사용함

- 성능은 다소 떨어질 수 있으나, 비용 효율성이 매우 우수하여 실용적인 대안으로 널리 활용됨

7.4 하이드

- 하이드(HyDE)는 검색 시스템의 성능을 향상시키는 혁신적인 접근방식

- 질의에 대한 가상의 이상적인 답변 문서를 먼저 생성한 후, 이를 기반으로 검색을 수행

[ 하이드 작동 과정 ]

1) 가상 문서 생성 단계 : LLM을 이용하여 이상적인 답변 문서 생성

2) 베딩 및 검색 단계 : 생성된 가상 문서를 임베딩 모델을 사용하여 벡터화한 후, 이를 기반으로 벡터 데이터베이스에서 유사한 문서 검색

3) 최종 답변 생성 단계 : 벡터 데이터베이스에서 검색된 관련 문서들을 컨텍스트로 활용하여 LLM이 최종 답변을 생성

728x90

반응형