4.1 LoRA 이론 및 실습

4.1.1 LoRA 개념

- 사전 학습된 대규모 모델(Pre-Trained Model)은 이미 방대한 데이터로 학습됐지만, 새로운 데이터를 처리하거나 특정 작업에 맞추려면 추가적인 파인 튜닝이 필요함

- 새로운 데이터를 반영하려고 전체 모델을 수정하는 것은 비효율적

- LoRA는 사전 학습된 모델의 구조를 그대로 유지하면서 필요한 만큼만 파라미터를 효율적으로 수정하는 방법

4.1.2 런팟 환경 설정

- H100PCIe x1

- Pytorch 2.1

- Container Disk 200GB

- Volume Disk 200GB

4.1.3 Gemma-2-9B-it 모델 준비

https://huggingface.co/google/gemma-2-9b-it

google/gemma-2-9b-it · Hugging Face

This repository is publicly accessible, but you have to accept the conditions to access its files and content. To access Gemma on Hugging Face, you’re required to review and agree to Google’s usage license. To do this, please ensure you’re logged in

huggingface.co

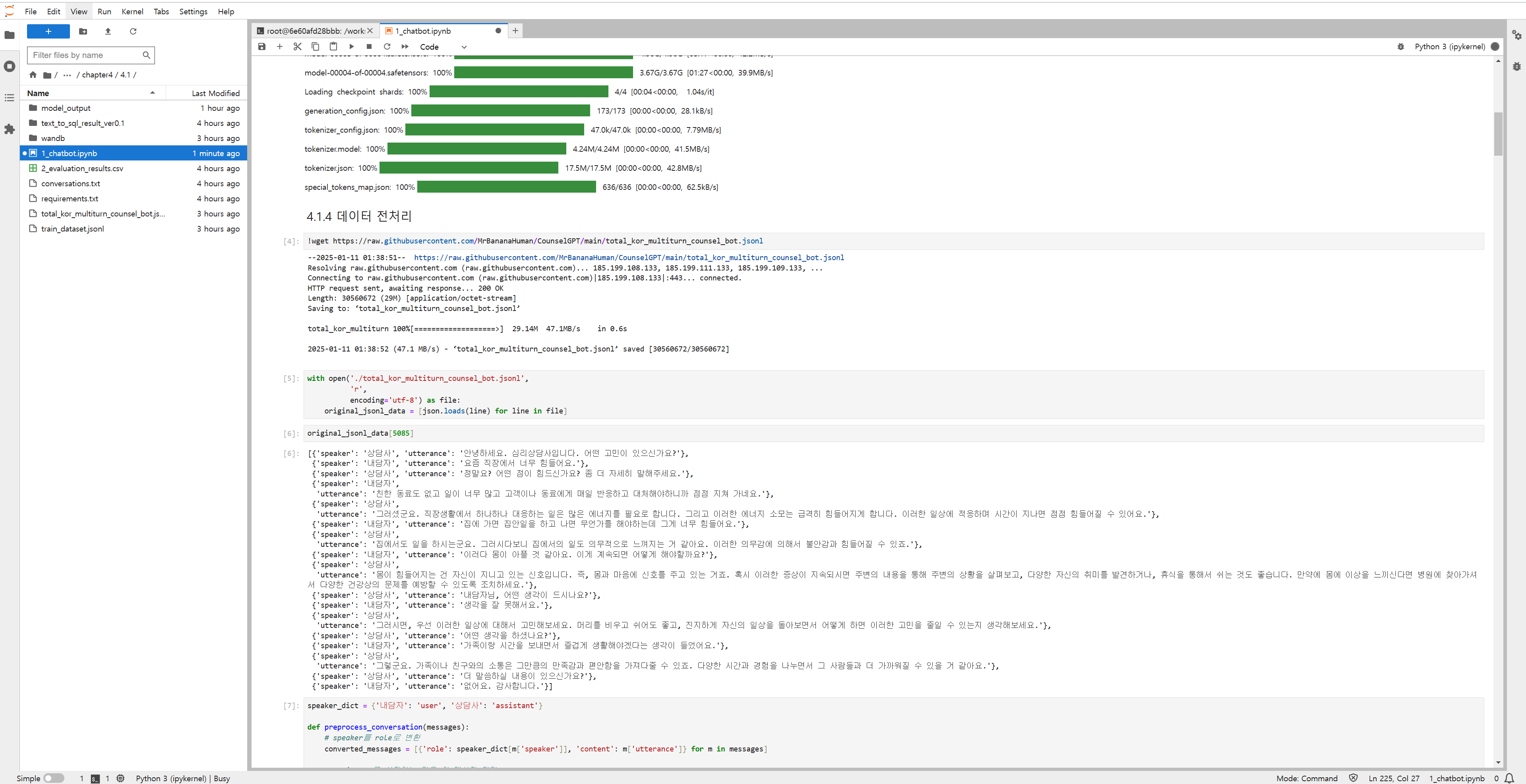

4.1.4 데이터 전처리

- 내담자와 상담사를 각각 user와 assistant로 변환

- 대화 흐름을 일관되게 user → assistant 순으로 정리

- assistant로시작하는 첫 메시지를 제거

- user로 끝나는 마지막 메시지들도 제거 - 연속으로 assistant 메시지가 나올 경우, 하나로 병합

4.1.5 LoRA 파라미터 설정

- '3.5.2 Llama 3.1 학습 파라미터 설정' 참고

https://31weeks.tistory.com/483

[Day10] 한 권으로 LLM 온라인 스터디 1기 - 다중 GPU Llama3 파인튜닝

3.5 다중 GPU를 활용한 Llama3.1-8B-instruct 파인 튜닝 3.5.1 런팟 환경 설정H100XM x 41Pytorch 2.2.0Container Disk 400GBVolume Disk 400GBgit clone https://github.com/wikibook/llm-finetuningcd llm-finetuning/chapter3/3.5pip install -r requirem

31weeks.com

'프로그래밍 > LLM' 카테고리의 다른 글

| [Day13] 한 권으로 LLM 온라인 스터디 1기 - 효율적인 파라미터 튜닝 (양자화 & QLoRA) (0) | 2025.01.26 |

|---|---|

| [Day12] 한 권으로 LLM 온라인 스터디 1기 - 효율적인 파라미터 튜닝 (LoRA 2) (0) | 2025.01.26 |

| [Day10] 한 권으로 LLM 온라인 스터디 1기 - 다중 GPU Llama3 파인튜닝 (1) | 2025.01.26 |

| [Day9] 한 권으로 LLM 온라인 스터디 1기 - 단일 GPU Gemma 파인튜닝 3 (0) | 2025.01.25 |

| [Day8] 한 권으로 LLM 온라인 스터디 1기 - 단일 GPU Gemma 파인튜닝 2 (0) | 2025.01.25 |